فایل روبوت (robots.txt) و نقش آن در سئو

فایل روبوت (robots.txt) فایلیه که به کرالرها میگه که چه صفحه هایی رو کرال نکنه. بیشنر سرچ انجین ها (مثل بینگ، گوگل، یاهو و …) این فایل رو بررسی و دستوراشو اجرا میکنن.

چرا فایل روبوت برای سئو مهمه؟

بیشتر وبسایت ها به به فایل روبوت احتیاجی ندارن.

به این دلیل که گوگل معمولا میتونه صفحات مهم سایتتون رو پیدا و اونا رو ایندکس کنه.

و همچنین میتونه به صورت اتوماتیک صفحاتی که مم نیستند یا نسخه های تکراری از صفات دیگه هستن رو ایندکس نکنه.

با این حال ۳ دلیل اصلی وجود داره که شما میخواید از فایل روبوت استفاده کنید.

مسدود کردن صفحات غیر عمومی: بعضی وقتا شما صفحاتی دارید که نمیخواید ایندکس شن. مثلا، شما ممکنه یه نسخه مرحله ایی از یک صفحه داشته باشد یا خود صفحه ورود و عضویت سایت.

اما شما نمیخواین که یوزر تصادفی وارد این صفحات بشه.

این موردیه که شما میتونید از فایل روبوت برای مسدود کردن این صفحات از کرال شدن توسط خزنده ها جلوگیری کنید.

بودجه کرال حداکثری: اگه شما جز اون دسته افرادی هستید که برای ایندکس شدن همه صفحات خود مشکل دارید، ممکنه مسئله بودجه کرال داشته باشید.

با مسدود کردن صفحات بی اهمیت، بات های گوگل میتونن بودجه خزش بیشتری رو صفحات مهم تری خرج کنید.

جلوگیری از ایندکس منابع: دستورات متا هم به خوبی فایل روبوت میتونن از ایندکس شدن جلوگیری کنن. با این حال این دستورات به خوبی برای منابع چند رسانه ایی مثل فایل های pdf و تصاویر کار نمیکنن.

اینجاست کع فایل robots.txt وارد عمل میشه.

نتیجه نهایی؟ فابل روبوا به کرالر ها میگه که یسری صفحات خاص رو ایندکس نکنن.

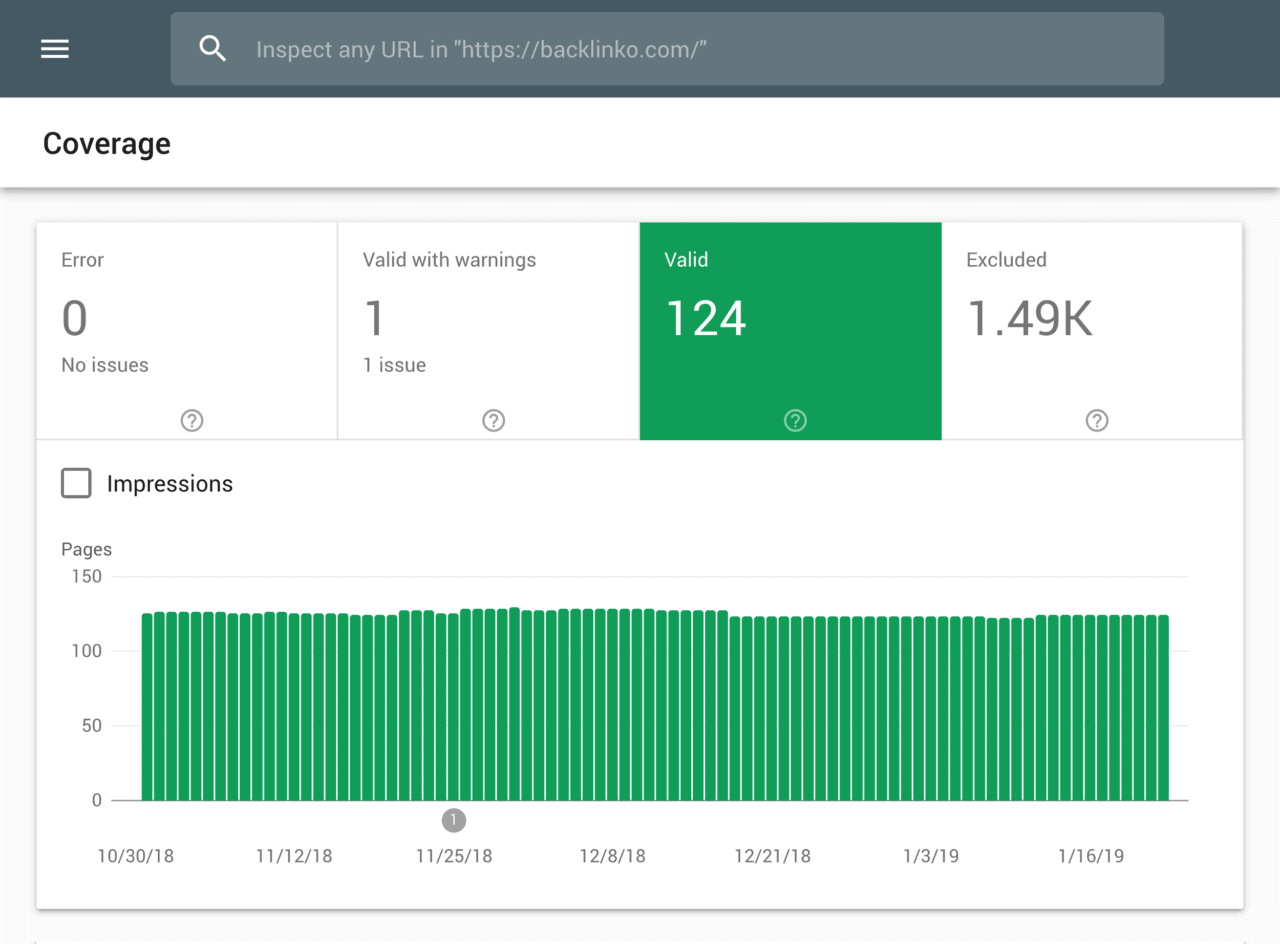

شما میتونید با استفاده از ابزار google search console چک کنید که چنتا از صفحاتتون ایندکس شدن.

اگه این تعداد با تعدادی که مد نظرته یکی بود، دیگه احتیاجی نیست خودتو درگیر robots.txt کنی.

ولی اگه تعدادش بیشتر از حد انتظاره (منظور صفحاتیه که نباید ایندکس بشن)، تو این حالت وقتشه که یه فایل روبوت ایجاد کنی.

آموزش ساخت فایل روبوت robots.txt

اولین قدم اینه که یه فایل روبوت بسازی (بی شوخی!)

برای اینکار شما میتونید از نوت پد ویندوز هم استفاده کنید.

و مهم نیست که چجوری فایل روبوت رو میسازید، فرمتش یکیه:

User-agent: X

Disallow: Y

User-agent روباتیه که دارید بهش دستور میدید.

و هرچیزی که بعد از Disallow میاد صفحاتی هستن که شما نمیخواین ایندکس بشن.

اینم یه مثال:

User-agent: googlebot

Disallow: /images

این دستور داره به بات های گوگل میگه که آدرس هایی که دایرکتوری image دارند رو ایندکس نکن.

شما همچنین میتونید از * برای دستور دادن به همه بات ها استفاده کنید.

مثال:

User-agent: *

Disallow: /images

این دستور به همه بات ها دستور میده که اون فولدر image رو کرال نکنن.

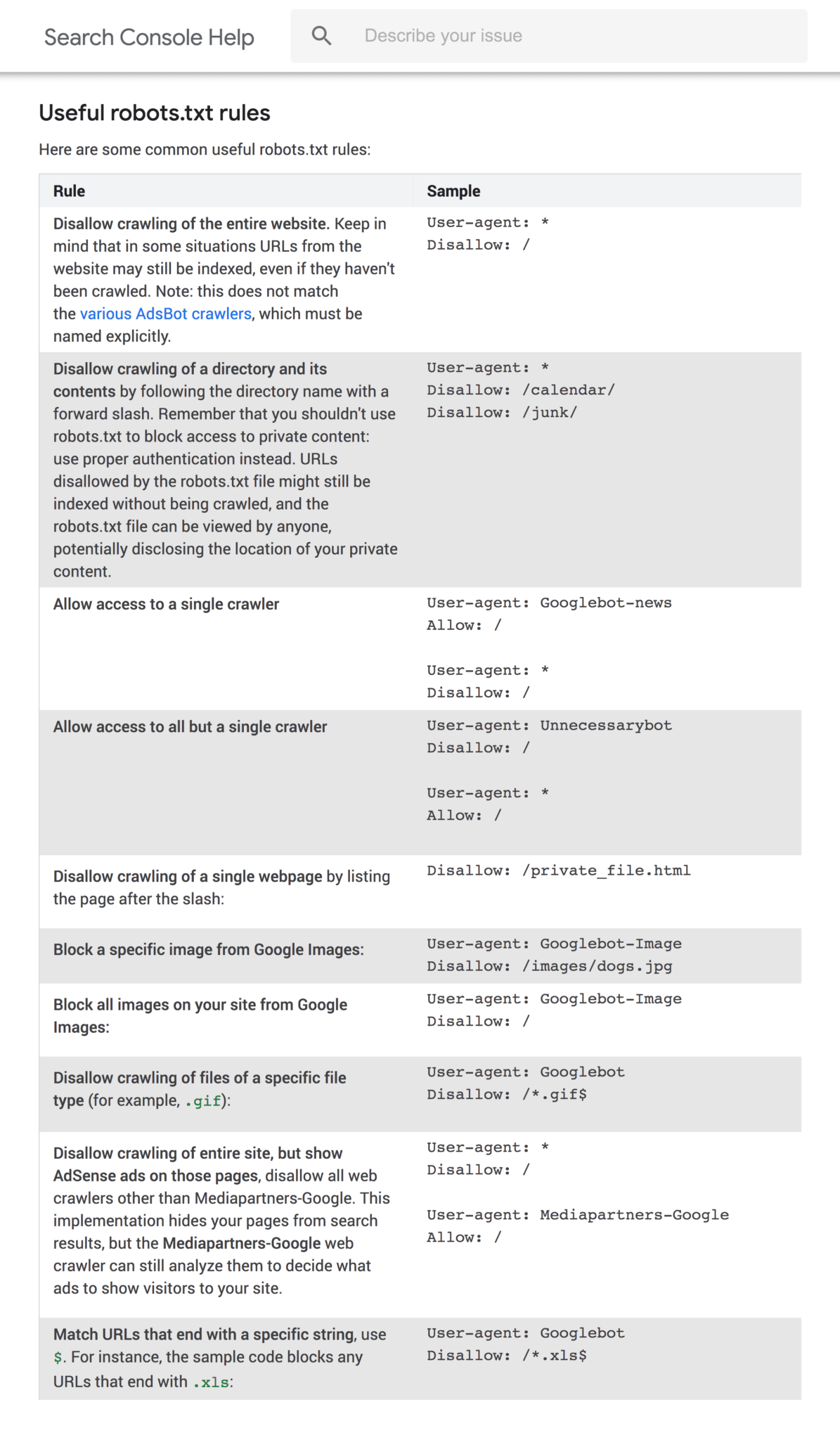

این فقط یکی از راه های استفاده از فایل پرکاربرد روبوته. این داکیومنت گوگل به شما کمک میکنه که از دستورات بیشتری برای کرالینگ یا بستن صفحات سایتتون استفاده کنید.

فایل روبوت رو کجای سایت باید بزاریم؟

حالا فایل روبوت رو ساختی الان وقتشه که ازش استفاده کنی.

شما فایل روبوت رو باید روی روت اصلی سایت آپلود کنید. مثل مسیر زیر:

https://example.com/robots.txt

(نکته مهم: فایل robots به حروف کوچیک و بزرگ حساسه. پس حتما مطمئن شید که با r کوچیک نامگذاری شده باشه)

خطاها و اشتباها رو بررسی کن

خیییییلی مهمه که فایل روبوت شما به صورت صحیح پیاده سازی شده باشه. یک اشتباه کافیه که کل سایت شما از ایندکس خادج بشه.

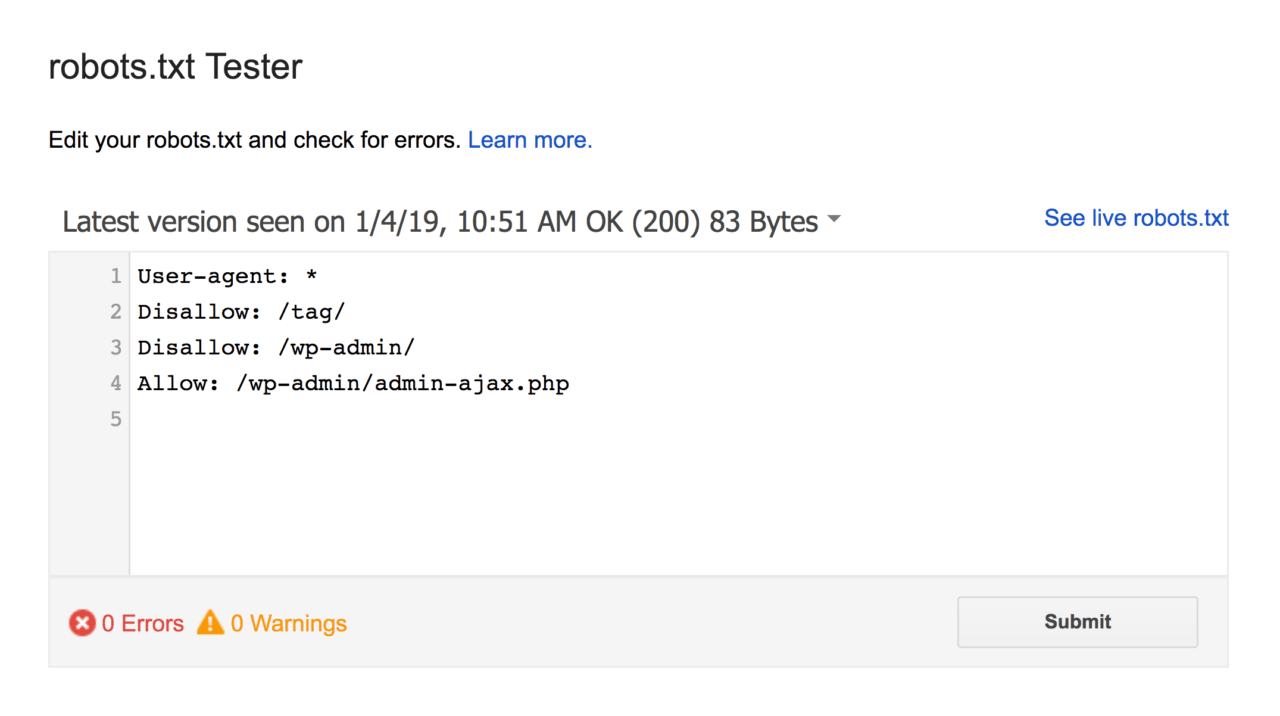

خوشبختانه نیازی نیست که حدس بزنید که ساختاری که تعریف کردید درسته یا نه. گوگل یه ابزار قوی تست برای اینکار داره:

این ابزار فایل robot و همه خطاها و وارنینگ های سایت شما رو نشون میده.

خب همونجوری که میبینید ما دسترسی کرالرها رو از کرال کردن صفحه ادمین وردپرس بستیم.

همچنین بات ها رو از کرال کردن صفحات تگ تو این فایل بستیم (برای جلوگیری از تولید صفحات تکراری)

از فایل روبوت باید استفاده کنیم یا متاتگ ها؟

چرا باید از فایل robots استفاده کنید درحالی که میتونید هر صفحه رو با استفاده از تگ noindex بلاک کنید؟

خب همونجوری که قبلا هم گفتم تگ نوایندکس برای پیاده سازی رو منابع چند رسانه ایی مثل ویدیو و فایل های pdf خیلی سخته.

همچنین اگه صفحه های زیادی دارید مسدود کردن اونا تو فایل روبوت خیلی راحتتر از تگ نو ایندکسه.

یسری مواردی هم وجود داره که نمیخواید با تگ نوایندکس هیج بودجه کرال برای بات های گوگل هدر بدید.

خارج از این ۳ مورد توصیه میکنم به جای فایل روبوت از دستورات متاتگ استفاده کنید. پیاده سازی اونا راحتتره و احتمال وقوع فاجعه هم کمتر میشه (مثل بلاک شدن کل سایت)